信息管理战略的组成部分

实施新流程之前,您应了解数据管理的不同组成部分,这一点很重要。

作者:David Loshin

企业在整个组织中部署信息管理最佳实践的业务驱动力主要有二。首先是为了满足普遍存在于多个不同行业中的共同需求,例如切实了解客户和产品以便增加收入并巩固客户关系。第二是为了满足行业特定的运营和分析需求。

这两个业务驱动力都要求企业更敏捷、更成熟地将精准定义的信息管理实践与构成端到端信息管理框架的技术相结合。

数据集成现已成为企业的命脉。

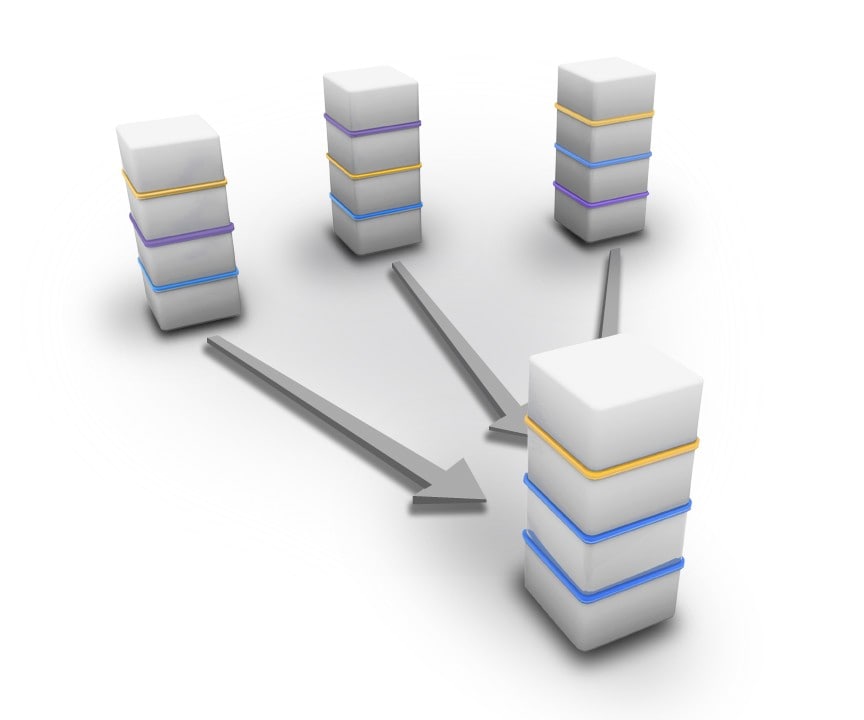

数据集成

数据集成现已成为企业的命脉。企业日益认识到跨业务部门实现数据共享是何等重要,为满足这一需求,他们必须提高数据集成的可靠性、性能和数据集成访问速度,尤其是在以下基础领域:

- 数据可访问性 – – 企业必须支持庞大的传统数据系统环境,尤其是当他们希望扫描历史数据资产以获得潜在的商业价值时。数据集成的一个关键点便是数据可访问性,先进的信息管理框架必须能够提供通往此类广泛数据源的连接器,包括基于文件的树形结构数据集、关系数据库甚至流数据源。

- 数据转换、交换和交付 – – 一旦数据集允许源头访问,数据集成框架就必须能在源和目的地之间有效地转移数据,必须能将数据从其原始格式转换为适宜的目标格式,同时能够验证数据集是否已被合理打包和传递。

- 数据复制和变更数据捕获 – – 面对不断增长的数据量,数据交付瓶颈导致企业无法在指定时段内控制数据的可访问性和数据交付,尤其是在从源系统定期提取数据期间以及向数据仓库中加载数据期间。数据复制技术可快速批量传输大型数据集。您可使用名为“变更数据捕获”的方法来监视系统日志并在源系统发生变化时触发更新目标系统。从而通过源源不断地馈送数据变更来实现进程同步。

数据虚拟化

当用户日益需要访问采用不同结构和格式的大量来源的数据时,高效数据集成可帮助应对某些相关挑战。但仍然无法解决及时一致地填充数据仓库以满足消费系统性能要求等问题。您在执行同步提取和转换数据的复杂任务时,您会遇到定时和同步问题,从而导致数据使用者与原始的源系统之间无法保持一致。

您可尝试通过缩短数据感知延迟和减小异步程度来解决此问题。数据虚拟化技术已经发展成熟,能够帮您排除这些顾虑。数据虚拟化工具和技术可提供以下三项主要功能:

- 联合 – – 这项功能可将标准或规范数据模型映射至面向包含联合模型的各类数据源的访问方法中,从而实现异构源的联合。

- 缓存 – – 通过在虚拟(“缓存”)环境中管理访问和聚合数据,数据虚拟化可缩短数据延迟,从而提高系统性能。

- 一致性 – – 联合和虚拟化功能结合在一起,可提取数据访问方法并将其与数据验证、清理和统一标准结合使用。

虚拟化数据环境可简化最终用户应用和业务数据分析人员的数据访问方式,无需他们了解源数据位置、数据集成或相关业务规则。

事件流处理

传统的商业智能系统可能不足以将实时事件信息的主动捕获、监控和关联转化为切实可用的知识。如想解决这个问题,您可通过名为“事件流处理”(ESP)的技术对流经信息流的事件之模式和序列进行实时监控。

ESP系统能帮企业快速响应因多个信息流汇合而带来的新机遇。这些系统允许信息管理专业人员模拟企业内部用户如何受到多个不同数据输入流的影响,并对触发产生心仪结果的模式进行分析。ESP系统可根据预期模式持续(实时)监控具有潜在影响的所有事件流,并能在指定的事件发生期内实现低延迟和事件处理。当发现实际情况与预期存在出入或新机会时,该系统可向适当人员发出警报,以便他们迅速采取行动,速度之快远非传统的数据分析工具可比。

ESP网络可以监视来自多个输入数据源的大量数据,具有极低的事件处理延迟。ESP系统具有延迟低和分析周转短等特点,能通过可扩展的方式持续监控大量的流数据源,从而允许您识别出并响应新情况。实质上,您可使用ESP针对许多既定模式同时搜索大量动态数据,无需对静态数据执行动态查询。

元数据管理

跨职能部门的数据共享与交换暴露了与各部门独立设计、开发和实施的数据系统相关的固有的不一致问题。鉴于早期的元数据管理方法只关注于数据模型的结构和技术层面(不考虑与业务相关的含义和语义),导致元数据管理项目经常徘徊不前。现代化企业信息管理环境必须能够实现业务导向的元数据管理,包括以下工具和方法:

- 业务术语词汇表,用于捕获常用的业务术语及其权威定义

- 数据标准,如命名惯例、既定的参考数据集、以及数据存储和交换标准

- 数据元素定义,用于反映数据与业务术语的关联性并提供上下文相关的定义以在业务应用中使用

- 数据谱系,用于显示数据元素概念与其在不同模型和应用中的表示法之间的关系

- 与数据治理策略相集成,以支持验证、合规性和控制

数据质量管理

数据质量管理的最佳业务实践旨在帮助企业提高识别数据缺陷和错误的精准度,并简化对数据缺陷根源的分析和修复流程。与此同时,数据质量保证工具和技术必须允许用户实现数据标准化,并在可能的情况下纠正错误数据、实时标记出新发现的问题、通知适当的数据管理员、并促成企业与源数据提供商就潜在数据问题进行交流。纳入以下技术的正式的数据质量管理框架可帮您实现上述目标:

- 数据解析和标准化 - 扫描数据值,旨在将非标准表示法转换为标准格式。

- 数据纠正和清理 - 应用数据质量规则来纠正已发现的数据错误,从而清理数据并消除不一致性。

- 数据质量规则管理 - 集中管理数据质量要求和规则,以验证数据是否符合预期规定。

- 数据质量评估和报告 - 提供服务调用框架,以根据数据规则来验证数据并报告异常和数据缺陷。

- 标准化数据集成验证 - 持续验证现有的数据集成流程并对新开发的数据集成流程实施嵌入式验证。

- 数据质量评估 - 使用数据分析和其他统计工具来评估源数据和数据问题,以识别出潜在的数据质量规则。

- 事故管理 - 数据质量事故管理的标准化方法(报告、分析/评估、分配优先级、补救、跟踪)。

数据治理

最后,如果缺少数据规则验证技术及数据政策合规保障技术,任何的现代化企业信息管理环境都将是不完整的。现代化企业信息管理环境至少应能通过适当工具来管理数据政策的整个生命周期,包括起草策略、向数据治理委员会提出策略、审查与修订、审批、以及规则的实际应用等。

这些任务必须与组织系统开发生命周期中的设计和开发任务保持一致。这一点适用于信息管理的整个生命周期,从数据使用者的需求分析与汇总、到概念建模、逻辑和物理设计、以及后续实施。

Knowledge Integrity, Inc.总裁David Loshin是数据质量、主数据管理和商业智能领域公认的思想领袖和专家顾问。

Read More

- More data management insights.