ETL

O que é e qual sua importância?

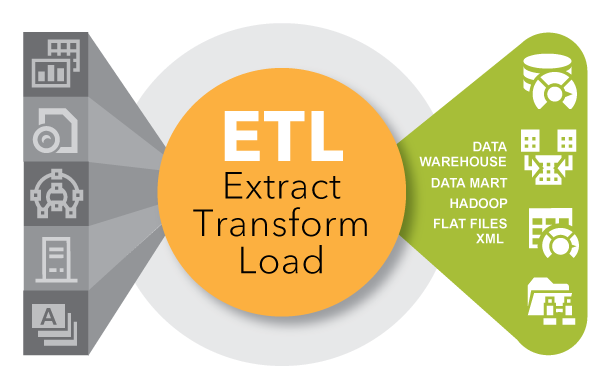

ETL é um tipo de data integration em três etapas (extração, transformação, carregamento) usado para combinar dados de diversas fontes. Ele é comumente utilizado para construir um data warehouse. Nesse processo, os dados são retirados (extraídos) de um sistema-fonte, convertidos (transformados) em um formato que possa ser analisado, e armazenados (carregados) em um armazém ou outro sistema. Extração, carregamento, transformação (ELT) é uma abordagem alternativa, embora relacionada, projetada para jogar o processamento para o banco de dados, de modo a aprimorar a performance.

História do ETL

ETL ganhou popularidade nos anos 1970, quando as organizações começaram a usar múltiplos repositórios ou bancos de dados para armazenar diferentes tipos de informações de negócios. A necessidade de integrar os dados que se espalhavam pelos databases cresceu rapidamente. O ETL tornou-se o método padrão para coletar dados de fontes diferentes e transformá-los antes de carregá-los no sistema-alvo ou destino.

No final dos anos 1980 e início dos 1990, os data warehouses entraram em cena. Sendo um tipo diferente de banco de dados, eles forneceram um acesso integrado a dados de múltiplos sistemas – computadores mainframes, minicomputadores, computadores pessoais e planilhas. Mas diferentes departamentos costumam usar diferentes ferramentas ETL com diferentes armazéns. Adicione isso a junções e aquisições, e muitas empresas acabam com distintas soluções ETL, que não foram integradas.

Com o tempo, o número de formatos, fontes e sistemas de dados aumentou muito. Extrair, transformar e carregar é, hoje, apenas um dos vários métodos que as organizações utilizam para coletar, importar e processar dados. ETL e ELT são, ambos, partes importantes de uma estratégia ampla de data integration das empresas.

Qual a importância do ETL?

Há anos, inúmeras empresas têm confiado no processo de ETL para obter uma visão consolidada dos dados que geram as melhores decisões de negócios. Hoje, esse método de integrar dados de múltiplos sistemas e fontes ainda é um componente central do kit de ferramentas de data integration de uma organização.

O ETL é usado para mover e transformar dados de múltiplas fontes, e carregá-los em vários destinos, como o Hadoop.

- Quando utilizado com um data warehouse corporativo (dados em repouso), o ETL fornece o contexto histórico completo para a empresa;

- Ao fornecer uma visão consolidada, o ETL facilita para os usuários corporativos a análise e a criação de relatórios sobre dados relevantes às suas iniciativas;

- O ETL pode melhorar a produtividade de profissionais analíticos, porque ele codifica e reutiliza processos que movem os dados sem que esses profissionais possuam a capacidade técnica de escrever códigos ou scripts;

- O ETL evoluiu ao longo do tempo para suportar os requisitos emergentes de integração para coisas como streaming data;

- As organizações precisam tanto de ETL quanto ELT para unir dados, manter a precisão e fornecer a auditoria necessária para armazenar dados, criar relatórios e realizar análises.

ETL no mundo de hoje

Os dados em fluxos velozes de hoje (streaming data) podem ser coletados e analisados em tempo real por meio de análises das transmissões. Essa abordagem apresenta a oportunidade de agir imediatamente, com base no que está acontecendo em um dado momento. Mas a visão histórica fornecida pelo ETL coloca os dados em um contexto. Por sua vez, as organizações obtêm um entendimento completo do negócio ao longo do tempo. Essas duas abordagens precisam trabalhar juntas.

7 Tips to Modernize Data Integration

Data integration has been around for years, but it still plays a vital role in capturing, processing and moving data. Follow these tips from TDWI to help guide your data integration modernization efforts.

Benefits of a Single Customer View

This energy company stored customer data on different systems and in different formats. With SAS® Data Management software, it cleansed and integrated records, reducing total records by 25 percent and increasing record completeness by 30 percent.

Data Integration Reimagined

Instead of dying out, old technologies often end up coexisting with new ones. Today, data integration is changing to keep pace with different data sources, formats and technologies. This paper shows how to keep your approach to data integration relevant.

SAS: Leader in the 2016 Gartner Magic Quadrant

Gartner has positioned SAS as a Leader in the 2016 Gartner Magic Quadrant for Data Integration Tools.

As organizações mais bem-sucedidas terão uma estratégia clara e precisa em funcionamento, que reconheça data integration como pilar fundamental de sua vantagem competitiva.

– David Loshin, President do Knowledge Integrity Inc. O novo panorama de data integration: indo além do ETL específico para uma estratégia corporativa de integração de dados

Softwares de Data Integration do SAS

Os softwares de data integration do SAS distribuem tarefas de integração através de qualquer plataforma e conectam-se virtualmente a qualquer banco de dados fonte ou alvo.

Como o ETL é usado?

Ferramentas centrais de ETL e ELT trabalham em conjunto com outras ferramentas de data integration e com outros vários aspectos do gerenciamento de dados – como data quality, data governance, virtualização e metadados. As utilizações populares de hoje incluem:

ETL e usos tradicionais

ETL é um método comprovado com o qual muitas empresas contam todos os dias – como varejistas, que precisam olhar os dados de vendas regularmente, ou operadoras de saúde procurando por um quadro preciso de seu uso. O ETL pode combinar e exibir dados de transações de um data warehouse ou outro banco de dados, de modo que eles estejam sempre prontos para analistas de negócios os visualizarem em um formato compreensível. O ETL também é utilizado para migrar dados de sistemas arcaicos para sistemas modernos, com diferentes formatos possíveis. É frequentemente usado para consolidar dados de fusões de empresas e para coletar e unir dados de fornecedores ou parceiros externos.

ETL com big data – transformações e adaptadores

Vence quem conseguir o maior número de dados. Embora isso não seja, necessariamente, uma verdade, ter acesso fácil a um amplo escopo de dados pode dar às empresas uma vantagem competitiva. Hoje, elas precisam de acesso a todo tipo de big data – vídeos, mídias sociais, a Internet das Coisas (IoT), logs do servidor, dados espaciais, dados abertos ou de crowdsource e muito mais. Fornecedores de ETL frequentemente adicionam novas transformações às suas ferramentas para suportar essas requisições emergentes e novas fontes de dados. Adaptadores oferecem acesso a uma ampla variedade de fontes de dados, e as ferramentas de data integration interagem com esses adaptadores para extrair e carregar dados de modo eficaz.

ETL para Hadoop – e mais

O ETL evoluiu para oferecer suporte à integração entre muito mais que data warehouses tradicionais. Ferramentas avançadas de ETL podem carregar e converter dados estruturados e não-estruturados no Hadoop. Essas ferramentas leem e escrevem múltiplos arquivos em paralelo de, e para, Hadoop, simplificando como informações são fundidas em um processo de transformação comum. Algumas soluções incorporam bibliotecas de transformações ETL pré-construídas para os dados de transação e interação que são executados em Hadoop. ETL também oferece suporte à integração entre sistemas transacionais, bancos de dados operacionais, plataformas de BI, centralizadores master data management (MDM) e a nuvem.

ETL e acesso aos dados self-service

Data preparation self-service é uma tendência de rápido crescimento que coloca o poder de acesso, mistura e transformação de dados nas mãos dos usuários organizacionais e outros profissionais não-técnicos. Sendo específico em sua natureza, essa abordagem aumenta a agilidade organizacional e libera a TI de abastecer usuários com diferentes formatos de dados. Menos tempo é desperdiçado na preparação de dados e mais tempo é gasto na geração de insights. Consequentemente, tanto profissionais de TI ou de outros ramos da organização podem melhorar sua produtividade e as empresas podem escalonar seu uso de dados para tomarem decisões melhores.

ETL e data quality

O ETL e outras ferramentas de data integration – utilizadas pra limpar, perfilar e auditar dados – garantem que os dados sejam confiáveis. As ferramentas ETL integram-se às de data quality, e fornecedores de ETL incorporam ferramentas relacionadas em suas soluções, como aquelas utilizadas para mapeamento e linhagem de dados.

ETL e metadados

Metadados nos auxiliam a entender a linhagem dos dados (de onde eles vieram) e seu impacto em outros ativos de dados na organização. Conforme arquiteturas de dados se tornam mais complexas, é importante rastrear como os diferentes elementos de dados na sua organização são utilizados e relacionados. Por exemplo, se você adiciona o nome de uma conta do Twitter à sua base de dados de clientes, você vai precisar saber o que será afetado, como, por exemplo, tarefas, aplicações ou relatórios ETL..

SAS® Data Management em Ação

Com o SAS Data Management, você pode fazer bom proveito de grandes volumes de dados – por exemplo, dados de clientes a partir de contas do Twitter – para obter insights como nunca. Matthew Magne explica como o SAS pode transmitir dados do Twitter para um data lake, limpá-los e analisá-los para, então, revelar quais clientes estão mais propensos a deixá-lo. Logo, você pode criar um plano para retê-los.

Como funciona?

O ETL está intimamente relacionado a várias outras funções, processos e técnicas de data integration. Compreendê-las fornece uma visão mais clara de como o ETL funciona.

| SQL | Linguagem de consulta estruturada (SQL, na sigla em inglês) é o método mais comum de acessar e transformar os dados de um database. |

| Tranformações, regras de negócios e adaptadores | Após extrair os dados, o ETL utiliza regras de negócios para transformá-los em novos formatos. Os dados transformados são, então, carregados no destino. |

| Data mapping | O mapeamento de dados (data mapping) é parte do processo de transformação. O mapeamento fornece instruções detalhadas para uma aplicação sobre como obter os dados necessários para processar. Ele também descreve qual campo de origem é mapeado para qual campo de destino. Por exemplo, o terceiro atributo de um feed de dados de atividades de um website pode ser o nome de usuário; o quarto pode ser o horário de quando a atividade aconteceu e o quinto pode ser o produto no qual o usuário clicou. Uma aplicação ou processo ETL, usando esses dados, teria que mapear esses mesmos campos ou atributos do sistema-fonte (por exemplo, a página de informações de atividade do site) no formato necessário pelo sistema de destino. Se o sistema de destino for um sistema de gestão de relacionamento com o cliente, ele pode primeiro armazenar o nome de usuário e o horário em quinto; ele pode nem sequer armazenar o produto. Nesse caso, uma transformação para formatar a data no formato esperado (e na ordem correta) pode acontecer enquanto os dados são lidos pela fonte e redigidos no destino. |

| Scripts | ETL é um método que automatiza os scripts (conjunto de instruções) que são executados no plano de fundo para mover e transformar os dados. Antes do ETL, scripts eram escritos individualmente em C ou COBOL para transferir dados entre sistemas específicos. Isso resultou em múltiplos bancos de dados executando diversos scripts. As primeiras ferramentas de ETL eram executadas em mainframes como um processo em lote. Ferramentas posteriores migraram para plataformas UNIX e PC. As organizações de hoje ainda utilizam tanto scripts quanto métodos de movimento programático de dados. |

| ETL versus ELT | No princípio, havia o ETL. Então, as empresas adicionaram o ELT, um método complementar. ELT extrai dados de um sistema-fonte, os carrega em um sistema de destino e, então, usa o poder de processamento do sistema-fonte para conduzir as transformações. Isso acelera o processamento de dados porque acontece onde os dados estão. |

| Data quality | Antes que os dados sejam integrados, um ambiente de teste é normalmente criado onde eles possam ser limpos e padronizados (SP e São Paulo, Senhor e Sr. ou Bia e Beatriz), endereços possam ser verificados e duplicatas, removidas. Muitas soluções ainda são independentes, mas procedimentos de data quality podem agora ser executados como uma das transformações no processo de data integration. |

| Agendando e processando | Ferramentas e tecnologias ETL podem fornecer tanto agendamento em lote quanto capacidades em tempo real. Elas podem também processar dados em altos volumes no servidor ou podem reduzir o processamento para o nível do banco de dados. Essa abordagem de processamento em um banco de dados, em vez de em um mecanismo especializado, evita duplicação dos dados e a necessidade de usar capacidades extras na plataforma do banco de dados. |

| Processamento em lote | ETL normalmente se refere a um processamento em lote que envolve a movimentação de grandes volumes de dados entre dois sistemas durante o que é chamado de “janela”. Nesse período de tempo determinado – por exemplo, entre o meio-dia e a uma da tarde – nenhuma ação pode ocorrer com o sistema-fonte, ou alvo, enquanto os dados são sincronizados. A maioria dos bancos realiza os processamentos em lote durante a noite para resolver transações que ocorrem durante o dia. |

| Web services | Web services são um método baseado na internet para fornecer dados ou funcionalidades a várias aplicações em tempo quase real. Esse método simplifica os processos de data integration e pode entregar, rapidamente, mais valor a partir dos dados. Por exemplo, imagine que um cliente entre em contato com a sua central de atendimento. Você poderia criar um web service que devolve o perfil completo do cliente em uma fração de segundo ao informar, simplesmente, um número de telefone para o web service que extrai os dados de múltiplas fontes ou de um hub MDM. Com um conhecimento mais rico do cliente, o atendente pode tomar decisões melhores sobre como interagir com esse cliente. |

| Master data management | MDM é o processo de unir os dados para criar uma visão única deles, através de múltiplas fontes. Ele inclui tanto ETL quanto capacidades de data integration para misturar as informações e criar um “registro de ouro” ou um “melhor registro”. |

| Data virtualization | Virtualização é um método ágil de misturar os dados para criar um panorama virtual sem movê-los. Data virtualization difere de ETL porque, embora mapeamento e combinação de dados ainda ocorram, não há a necessidade de uma tabela de teste física para armazenar os resultados. Isso porque o panorama é geralmente armazenado na memória e em cachê para melhorar a performance. Algumas soluções de data virtualization, como a SAS Federation Server, fornecem funções dinâmicas de mascaramento de dados, aleatorização e hashing para proteger dados confidenciais de grupos específicos. O SAS também fornece data quality sob demanda enquanto a exibição é gerada. |

| Event stream processing and ETL | Quando a velocidade dos dados aumenta para milhões de eventos por segundo, event stream processing pode ser usado para monitorar e processar fluxos de dados, e ajudar a tomar decisões mais rapidamente. Um exemplo no setor de produção de energia é utilizar análises preditivas em fluxos de dados para detectar quando uma bomba submersa precisa de reparo, reduzindo o tempo de inatividade, além do escopo e do tamanho do dano à bomba. |

Leia mais sobre este assunto

-

Key questions to kick off your data analytics projectsThere’s no single blueprint for starting a data analytics project. Technology expert Phil Simon suggests these 10 questions as a guide.

-

What is a data lake & why does it matter?As containers for multiple collections of data in one convenient location, data lakes allow for self-service access, exploration and visualization. In turn, businesses can see and respond to new information faster.

-

5 data management best practices to help you do data rightFollow these 5 data management best practices to make sure your business data gives you great results from analytics.

-

Data lineage: Making artificial intelligence smarterLear how data lineage plays a vital role in understanding data, making it a foundational principle of AI.